Tech stack voor machine learning

Inleiding

Machine learning-projecten draaien niet alleen om het ontwikkelen van modellen. Net zo belangrijk zijn de infrastructuur en de ondersteunende tools die ervoor zorgen dat experimenten herhaalbaar zijn, data goed beheerd wordt en resultaten betrouwbaar te reproduceren zijn. Op basis van onze ervaring raden wij TensorFlow aan als framework, het gebruik van experiment tracking doormiddel van MLflow en het goed beheren van data met DVC (Data Version Control).

Machine learning frameworks

Bij het bouwen van modellen vormt het gekozen framework vaak het startpunt. Zonder een framework zou elke matrixvermenigvuldiging, convolutie of backpropagatie handmatig geprogrammeerd moeten worden. Een framework bespaart niet alleen tijd, maar maakt het ook mogelijk om efficiënt te werken op GPU’s en TPU’s en later modellen in te zetten in productie.

Voor projecten waarin zowel snelle prototyping als productie deployment belangrijk zijn, is TensorFlow de beste keuze. Het biedt Keras voor eenvoudige modelontwikkeling en TensorFlow Serving/Lite voor deployment. Alternatieven zoals PyTorch en JAX zijn krachtig voor onderzoek, maar minder geschikt voor productie. Kies deze alleen als flexibiliteit in onderzoek belangrijker is dan stabiliteit.

Experiment tracking

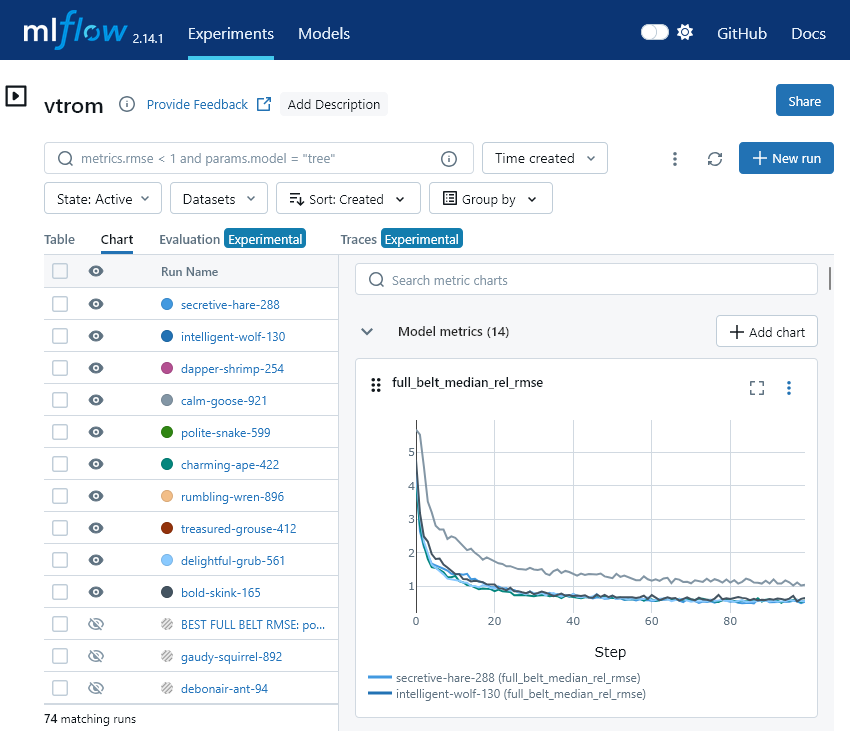

Bij het trainen van modellen worden soms tientallen runs uitgevoerd met kleine variaties in hyperparameters of architectuur. Zonder goed systeem ontstaat er al snel onduidelijkheid: welke instellingen leverden het beste resultaat op, en waarom?

Om dit bij te houden kan er gebruik gemaakt worden van experiment tracking software. Wij adviseren hiervoor MLflow vanwege de mogelijkheid om lokaal en self-hosted te draaien. MLflow maakt het eenvoudig om parameters, resultaten en modelversies te registreren en te vergelijken. Dit blijkt vooral waardevol in situaties waarin verschillende teamleden parallel werken en hun resultaten willen delen. Daarnaast geeft de mogelijkheid om modellen centraal op te slaan en te versioneren ons een duidelijke meerwaarde, het is makkelijker om terug te gaan naar eerdere runs en modellen opnieuw uit te rollen. Hoewel een tool zoals Weights & Biases sterke visualisaties biedt, is het afhankelijk van SaaS en minder geschikt voor teams die privacy en controle belangrijk vinden.

Uit onze ervaringen hebben we geleerd dat experiment tracking niet optioneel is, maar een kernonderdeel van ieder ML-proces moet zijn. Het bespaart tijd, voorkomt verwarring en maakt beslissingen beter onderbouwd.

Datamanagement

Data vormt de basis van elk machine learning-project. Zonder goed beheer kan data snel inconsistent worden, wat leidt tot onbetrouwbare modellen en moeilijk reproduceerbare resultaten. Door datasets te versioneren en wijzigingen traceerbaar te maken, blijft het mogelijk om experimenten te herhalen en modellen te valideren. Daarom adviseren wij het gebruik van DVC voor versiebeheer van datasets en ML-artefacten en voor schaalbare opslag en traceerbaarheid tools zoals Delta Lake of BigQuery.

Conclusie

Voor een robuuste ML-workflow adviseren wij:

- Framework: TensorFlow

- Experiment tracking: MLflow

- Datamanagement: DVC/Delta Lake

Deze keuzes bieden stabiliteit, reproduceerbaarheid en controle over infrastructuur, en vormen een solide basis voor toekomstige projecten.

Meer informatie

Zie ook onze diensten op het gebied van machine learning. Neem gerust contact met ons op als u meer wilt weten. Als u op de hoogte wilt blijven van de tools en technieken waar we mee bezig zijn dan is onze nieuwsbrief een goede optie.